Wissen

Wie bereiten wir Mitarbeitende auf KI vor? – KI-Kompetenzen (AI Literacy) am Arbeitsplatz veranschaulichen, messen und fördern

Veröffentlicht am 08. Okt 2024

KI transformiert viele Arbeitsplätze. Auch Menschen, die bisher wenig technische Berührungspunkte hatten, werden über kurz oder lang mit KI zusammenarbeiten, sei es durch unterstützende Vorschläge oder sogar in Mensch-KI-Teams. Messungen und innovative Weiterbildungsmethoden können Beschäftigte bei der durch KI bedingten Transformation ihrer Arbeitswelt unterstützen. Dieser Artikel legt den Fokus auf die Operationalisierung sowie Messung von KI-Kompetenzen und auf Ansätze zur KI-Kompetenzentwicklung von Nutzenden in verschiedenen Arbeitskontexten.

Einflussfaktoren der Mensch-KI-Interaktion

Menschen übertragen Erwartungen und Verhalten, die sie aus der Mensch-Mensch-Interaktion kennen, auf die Interaktion mit Technik. [1] Mit zunehmend menschenähnlichen Erscheinungsformen von KI erwarten KI-Nutzende auch, dass KI-Systeme über bestimmte soziale Kompetenzen und Funktionen verfügen (Anthropomorphismus). [2] Nicht alle Erwartungen der Menschen an die KI sind jedoch allgemeingültig. Menschen sind divers; sie unterscheiden sich in ihren Bedürfnissen in der Interaktion mit sozialen und technischen Partner*innen. Während manche Menschen eine eher einfache und funktionale Interaktion erwarten, steht für andere der soziale Austausch im Zentrum. [3] Die Gestaltung und Passung, bestimmen dann wie viel Vertrauen und Kompetenz der KI zugeschrieben wird. Dabei werden menschliche Gestaltmerkmale gezielt eingesetzt, um Vertrauen zu erhöhen, was zu Täuschung und Over-Trust führen kann. Andererseits können auch negative Einstellungen und Ängste gegenüber KI zur Ablehnung führen. [3] Zusammengefasst zeigt die aktuelle Forschung, dass Eigenschaften der KI-Nutzenden sowie des KI-Systems die Gelingensbedingungen von Mensch-KI-Interaktionen determinieren. [4]

Von AI Anxiety zu AI Literacy

Um möglichst viele Menschen bei der Transformation ihrer Arbeitswelt durch KI zu unterstützen, gilt es psychologische Barrieren zu überwinden und KI-Systeme bedürfniszentriert zu gestalten. Das Forschungsprojekt „AI Literacy at Work“ entwickelt und erforscht innovative Methoden, um die Transformation menschenzentriert zu gestalten und KI-Ängste (AI Anxiety) in KI-Kompetenzen (AI Literacy) zu verwandeln. Das Projekt nimmt dabei zwei Perspektiven ein und fokussiert sowohl die Gestaltung von KI-Systemen in verschiedenen Arbeitskontexten, von der Produktion bis in die Verwaltung, als auch die Kompetenzentwicklung (AI Literacy) von Nutzenden.

AI Literacy als Schlüssel zur zukünftigen selbstbestimmten Teilhabe am Arbeitsmarkt

Der Begriff „AI Literacy“ steht für eine Gruppe verschiedener Kompetenzen, die es dem Menschen erlauben, KI kritisch zu evaluieren und effektiv mit ihr zu kommunizieren und zusammenzuarbeiten. [5] Je nach Konzeptualisierung [5], [6] und angewendetem Messmodell [7], [8] werden verschiedene Kompetenzen darunter gefasst. Wichtige Teilbereiche sind die Bedienung der KI, die Reflektion ethischer und rechtlicher Gesichtspunkte mit KI-Bezug sowie das Erkennen von KI bzw. Unterscheiden von Mensch und KI. Einige Forschende zählen die Fähigkeit KI zu erstellen ebenso zur AI Literacy. Carolus und Wienrich erweitern dieses Kompetenzspektrum um psychologische Kompetenzen (Lebenskompetenzen). [9] Dazu zählt man eine Reihe von vielfältigen Kompetenzen, die zum selbstständigen Denken, Handeln und Problemlösen notwendig sind. Im Angesicht von Veränderung sind etwa die Fähigkeiten Probleme zu lösen, Emotionen zu regulieren, sich der eigenen Kompetenzen bewusst zu sein, Manipulationen zu erkennen und stets auf dem neuesten Stand zu bleiben, zentral. Das Forschungsprojekt AI Literacy at Work hat alle aktuellen Messinstrumente und Konstrukte in diesem Bereich wissenschaftlich analysiert und erstmalig ein umfassendes Messinstrument entwickelt. [7] Die sogenannte Meta AI Literacy Scale (kurz: MAILS) ist wissenschaftlich fundiert. Sie misst die Fähigkeiten, KI zu nutzen und anzuwenden, KI zu verstehen, KI zu erkennen, KI ethisch zu reflektieren und KI zu entwickeln. Außerdem legt sie im Gegensatz zu bisherigen Messinstrumenten einen starken Fokus auf psychologische Kompetenzen. Dazu zählen die Selbstwirksamkeit beim Lernen und Problemlösen im Umgang mit KI und die Bewältigung eigener Emotionen genauso wie die Wahrnehmung und Kontrolle von Beeinflussungsversuchen durch die Technologie.

Übersicht:

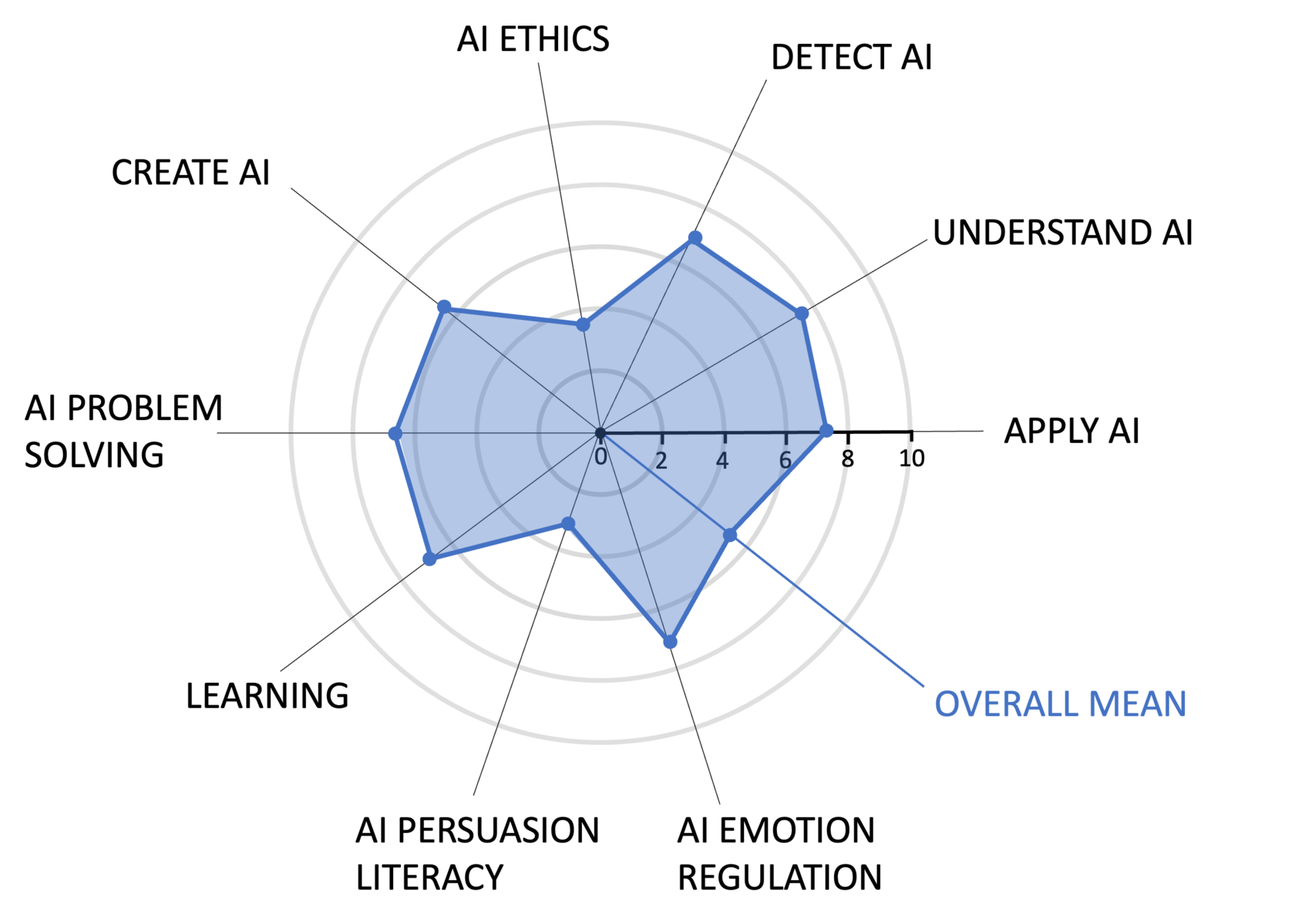

Die Grafik zeigt, wie nach dem Ausfüllen des Fragebogens, die Ergebnisse des Messinstruments „Meta AI Literacy Scale“ (MAILS) dargestellt werden. Ein Spinnennetzdiagramm visualisiert die Fähigkeiten KI zu nutzen und anzuwenden, KI zu verstehen, KI zu erkennen, KI ethisch zu reflektieren und KI zu entwickeln.

Darstellung:

Es ist ein Spinnennetzdiagramm, auf weißem Hintergrund zu sehen. Vom Mittelpunkt ausgehend sind fünf konzentrische Kreise platziert, die durch eine Skala von 0 (Mittelpunkt) bis 10 (äußerster Kreis) beschriftet sind. Es sind zehn Merkmale an Achsen, die vom Mittelpunkt aus nach außen verlaufen, eingezeichnet. Diese sind wie folgt von oben im Uhrzeigersinn beschriftet: Detect AI, Understand AI, Apply AI, Overall Mean, AI Emotion Regulation, AI Persuasion Literacy, Learning, AI Problem Solving, Create AI, AI Ethics.

Auf dem Diagramm ist eine hellblaue Fläche eingezeichnet, die jedem Merkmal einen Datenpunkt zuweist. Die Datenpunkte der zehn Merkmale sind miteinander verbunden. Große Ausprägung (etwa 7-8 Punkte) sind bei "Understand AI", "Apply AI", "Detect AI" und "AI Emotion Regulation" zu sehen. Geringe Ausprägung (unter 4 Punkte) gibt es bei "AI Ethics" und "AI Persuasion Literacy". Der "Overall Mean" liegt bei etwas über 5 Punkte auf der Skala.

Die Skala ist frei verfügbar und kann modular eingesetzt werden. Das heißt, dass einzelne Aspekte, die für bestimmte Arbeitskontexte wichtig sind, gezielt herausgegriffen werden können. Damit ist das Instrument auch in der Praxis gut anwendbar. Die Meta AI Literacy Scale kann genutzt werden, um Kompetenzstufen zu erfassen, Entwicklungsbedarfe zu identifizieren und Weiterbildungserfolg zu messen. Sie ist somit interessant für Unternehmen, die ihre Beschäftigte auf die Einführung einer KI vorbereiten oder kontinuierlich die Entwicklung von KI-Kompetenzen im Blick haben wollen. Nach Durchführung und Auswertung der Meta AI Literacy Scale, können aus den gewonnenen Daten individuelle Fortbildungsbedarfe abgeleitet werden. Für jede mitarbeitende Person kann ein individuelles und anschauliches Kompetenzprofil erstellt werden: Stärken und Schwächen in verschiedenen Bereichen können sichtbar gemacht und anschließend durch zielgerichtete Fortbildungs- und Trainingsangebote adressiert werden. Unternehmen können so wissenschaftlich fundiert auch Fortbildungsangebote ableiten.

Auch für Beschäftigte, die eigenständig mit der Integration von KI in ihren Arbeitsalltag beginnen wollen, bietet die MAILS die Möglichkeit zu einem Selbsttest. Die Auswertung erfolgt automatisiert auf der Projektwebsite. Die Nutzer*innen können ihr Ergebnis herunterladen und gezielt nach Weiterbildungsangeboten in für sie relevanten Bereichen suchen. Für Unternehmen und Beschäftigte ist eine kurze Erhebungsmethode wichtig, daher wird neben dem modularen Aufbau in Kürze auch eine fundierte Kurzversion zur Verfügung stehen.

Mensch-KI-Testzentrum hilft bei menschenzentrierter KI-Entwicklung

Zu einer menschenzentrierten KI-Entwicklung gehört gleichsam die bedürfnisgerechte Gestaltung der KI-Systeme selbst. Es ist notwendig KI so zu gestalten, dass sie den kommunikativen, informativen und sozialen Bedürfnissen der Menschen gerecht wird. [9] Studien zeigen, dass Menschen, die an der Gestaltung von digitalen Arbeitstools beteiligt werden, später besser mit diesen arbeiten und eine höhere Arbeitszufriedenheit aufweisen. [10] Daher ist es unabdingbar, Menschen an der Gestaltung von KI-Systemen, mit denen sie später zusammenarbeiten werden, zu beteiligen.

Die nahezu unendlichen Designmöglichkeiten stellen jedoch eine große Herausforderung dar. Das Projekt AI Literacy at Work nutzt einen ganz neuen Ansatz. Für die Gestaltung der KI greift das Projekt in ihrem Mensch-KI-Testzentrum auf verschiedene Simulationen (u.a. Videosimulationen, eXtended Reality, also virtuelle und augmentierte Simulationen) zurück, die zukünftige KI-Systeme und Mensch-KI-Interaktionen realitätsnah abbilden können. [11] So lassen sich Funktion und Erscheinungsformen eines KI-Systems auf Knopfdruck variieren. Außerdem können so gut wie jeder Arbeitskontext sowie verschiedene Aufgaben und Arbeitsbelastungen nachgestellt werden. Das Mensch-KI-Testzentrum vereinfacht nicht nur die ansonsten aufwändige und schwer zu realisierende Testung verschiedener KI-Systeme deutlich, sondern macht die für jedes Unternehmen zugänglich. Zukünftige Nutzende können frühzeitig in die Entwicklung einbezogen werden und so an der Umgestaltung ihres Arbeitsumfeldes aktiv und konstruktiv mitwirken. Das Testzentrum kann auch dafür genutzt werden, die zukünftige Zusammenarbeit mit KI einzuüben, Sicherheit und Vertrauen zu gewinnen und Weiterbildungsmaßnahmen anschaulich und praxisnah zu gestalten.

Zusammengefasst trägt das Forschungsprojekt AI Literacy at Work dazu bei, die Diversität von Menschen in der Transformation des Arbeitsmarktes durch KI angemessen zu berücksichtigen. Die Simulation von verschiedenen KI-Systemen in verschiedenen Arbeitskontexten, von der Produktion zur Verwaltung, ermöglicht eine menschenzentrierte Entwicklung und Einführung von KI-Systemen sowie eine frühe Beteiligung aller zukünftigen Nutzenden. KI-Kompetenzen und psychologische Barrieren und Ressourcen können wissenschaftlich fundiert und praxisnah durch das Messinstrument Meta AI Literacy Scale erfasst werden und so evidenzbasiert Weiterbildungsmaßnahmen begleiten. Dies ermöglicht es Unternehmen und Beschäftigten, sich optimal auf die Integration von KI in den Arbeitsalltag vorzubereiten.

Einzelnachweise

1 Nass, C., & Moon, Y. (2000). Machines and Mindlessness: Social Responses to Computers. Journal of Social Issues, 56(1), 81–103. https://doi.org/10.1111/0022-4537.00153

2 Carolus, A., Wienrich, C., Törke, A., Friedel, T., Schwietering, C., & Sperzel, M. (2021). ‘Alexa, I feel for you!’ Observers’ Empathetic Reactions towards a Conversational Agent. Frontiers in Computer Science, 3, 682982. https://doi.org/10.3389/fcomp.2021.682982

3 Wienrich, C., Carolus, A., Markus, A., Augustin, Y., Pfister, J., & Hotho, A. (2023). Long-term effects of perceived friendship with intelligent voice assistants on usage behavior, user experience, and social perceptions. Computers, 12(4), 77.

4 Kaplan, A. D., Kessler, T. T., Brill, J. C., & Hancock, P. A. (2023). Trust in Artificial Intelligence: Meta-Analytic Findings. Human Factors: The Journal of the Human Factors and Ergonomics Society, 65(2), 337–359. https://doi.org/10.1177/00187208211013988

5 Carolus, A., Augustin, Y., Markus, A., & Wienrich, C. (2023). Digital interaction literacy model – Conceptualizing competencies for literate interactions with voice-based AI systems. Computers and Education: Artificial Intelligence, 4, 100114. https://doi.org/10.1016/j.caeai.2022.100114

6 Ng, D. T. K., Leung, J. K. L., Chu, S. K. W., & Qiao, M. S. (2021). Conceptualizing AI literacy: An exploratory review. Computers and Education: Artificial Intelligence, 2, 100041. https://doi.org/10.1016/j.caeai.2021.100041

7 Carolus, A., Koch, M. J., Straka, S., Latoschik, M. E., & Wienrich, C. (2023). MAILS - Meta AI literacy scale: Development and testing of an AI literacy questionnaire based on well-founded competency models and psychological change- and meta-competencies. Computers in Human Behavior: Artificial Humans, 1(2), 100014. https://doi.org/10.1016/j.chbah.2023.100014

8 Wang, B., Rau, P.-L. P., & Yuan, T. (2023). Measuring user competence in using artificial intelligence: Validity and reliability of artificial intelligence literacy scale. Behaviour & Information Technology, 42(9), 1324–1337. https://doi.org/10.1080/0144929X.2022.2072768

9 Capel, T., & Brereton, M. (2023). What is Human-Centered about Human-Centered AI? A Map of the Research Landscape. Proceedings of the 2023 CHI Conference on Human Factors in Computing Systems, 1–23. https://doi.org/10.1145/3544548.3580959

10 Carls, K, Gehrken, H., Kuhlmann, M., Thamm, L., & Splett, B. (2021). Digitalisierung, Arbeit und Gesundheit. In Buss, K-P., Kuhlmann, Weißmann, Wolf, H., & Apitzsch, B. (Hrsg.), Digitalisierung und Arbeit – Triebkräfte, Arbeitsfolgen, Regulierung (1. Aufl., S.235-273). Frankfurt, Campus Verlag.

11 Wienrich, C., & Latoschik, M. E. (2021). eXtended Artificial Intelligence: New Prospects of Human-AI Interaction Research. Frontiers in Virtual Reality, 2, 686783. https://doi.org/10.3389/frvir.2021.686783